Comparativa: Literatura española contra literatura inglesa

Índice

Información General

| Título: | * |

|---|

| Autor: | * |

|---|

| Idioma: | Castellano |

|---|

| #Palabras total: | 1800906 |

|---|

| #Palabras distintas: | 76810 |

|---|

| Type-Token ratio: | 4.27% |

|---|

|

| Título: | * |

|---|

| Autor: | * |

|---|

| Idioma: | Inglés |

|---|

| #Palabras total: | 1323714 |

|---|

| #Palabras distintas: | 28903 |

|---|

| Type-Token ratio: | 2.18% |

|---|

|

Ley de Heaps - Saturación léxica

La Ley de Heaps es una ley empírica que predice el tamaño del vocabulario dado un texto.

Esto es, nos da una estimación del número de palabras distintas (v) dado el número total de palabras (n) de que consta el texto,

según la fórmula

v = K*n^b

donde b está entre 0 y 1 (habitualmente entre 0.4 y 0.6)

y K es una cierta constante, habitualmente entre 10 y 100.

En particular, mayores valores de b se corresponden con vocabularios más grandes,

en el sentido de que aumentan rápidamente;

mientras que se tienen valores menores de b cuando casi todo el vocabulario aparece al principio

y luego se van añadiendo muy pocos términos nuevos (el vocabulario se satura rápidamente).

| Castellano | Inglés |

|---|

| #Palabras: | #Palabras distintas: |

|---|

| 36018 | 5706 |

| 72036 | 11046 |

| 108054 | 14561 |

| 144072 | 17696 |

| 180090 | 20200 |

| 216108 | 21997 |

| 252126 | 23464 |

| 288144 | 24611 |

| 324162 | 25754 |

| 360180 | 27048 |

| 396198 | 28321 |

| 432216 | 29474 |

| 468234 | 30611 |

| 504252 | 31605 |

| 540270 | 32583 |

| 576288 | 34920 |

| 612306 | 36999 |

| 648324 | 38836 |

| 684342 | 40455 |

| 720360 | 41950 |

| 756378 | 43172 |

| 792396 | 44394 |

| 828414 | 45454 |

| 864432 | 46436 |

| 900450 | 47394 |

| 936468 | 48173 |

| 972486 | 50942 |

| 1008504 | 52746 |

| 1044522 | 54236 |

| 1080540 | 55220 |

| 1116558 | 56054 |

| 1152576 | 56826 |

| 1188594 | 57533 |

| 1224612 | 58207 |

| 1260630 | 58817 |

| 1296648 | 59339 |

| 1332666 | 60002 |

| 1368684 | 60926 |

| 1404702 | 61908 |

| 1440720 | 65447 |

| 1476738 | 68505 |

| 1512756 | 69268 |

| 1548774 | 70229 |

| 1584792 | 71196 |

| 1620810 | 71937 |

| 1656828 | 72696 |

| 1692846 | 73642 |

| 1728864 | 74555 |

| 1764882 | 75449 |

| 1800900 | 76810 |

| 1800906 | 76810 |

|

| #Palabras: | #Palabras distintas: |

|---|

| 26474 | 3967 |

| 52948 | 5917 |

| 79422 | 7099 |

| 105896 | 7964 |

| 132370 | 8728 |

| 158844 | 9468 |

| 185318 | 10064 |

| 211792 | 10928 |

| 238266 | 11577 |

| 264740 | 12214 |

| 291214 | 12727 |

| 317688 | 13241 |

| 344162 | 13764 |

| 370636 | 14146 |

| 397110 | 14572 |

| 423584 | 15237 |

| 450058 | 16085 |

| 476532 | 16923 |

| 503006 | 17544 |

| 529480 | 18110 |

| 555954 | 18664 |

| 582428 | 19148 |

| 608902 | 19847 |

| 635376 | 20541 |

| 661850 | 21042 |

| 688324 | 21698 |

| 714798 | 22294 |

| 741272 | 22702 |

| 767746 | 22999 |

| 794220 | 23299 |

| 820694 | 23573 |

| 847168 | 23841 |

| 873642 | 24255 |

| 900116 | 24715 |

| 926590 | 25059 |

| 953064 | 25366 |

| 979538 | 25674 |

| 1006012 | 26025 |

| 1032486 | 26261 |

| 1058960 | 26519 |

| 1085434 | 26745 |

| 1111908 | 26900 |

| 1138382 | 27158 |

| 1164856 | 27413 |

| 1191330 | 27656 |

| 1217804 | 27896 |

| 1244278 | 28178 |

| 1270752 | 28475 |

| 1297226 | 28666 |

| 1323700 | 28903 |

| 1323714 | 28903 |

|

|

Ajuste por mínimos cuadrados de los datos a K*n^b: |

| Castellano |

|

Inglés |

| K = 10.669 |

|

K = 18.351 |

| b = 0.615 |

|

b = 0.524 |

|

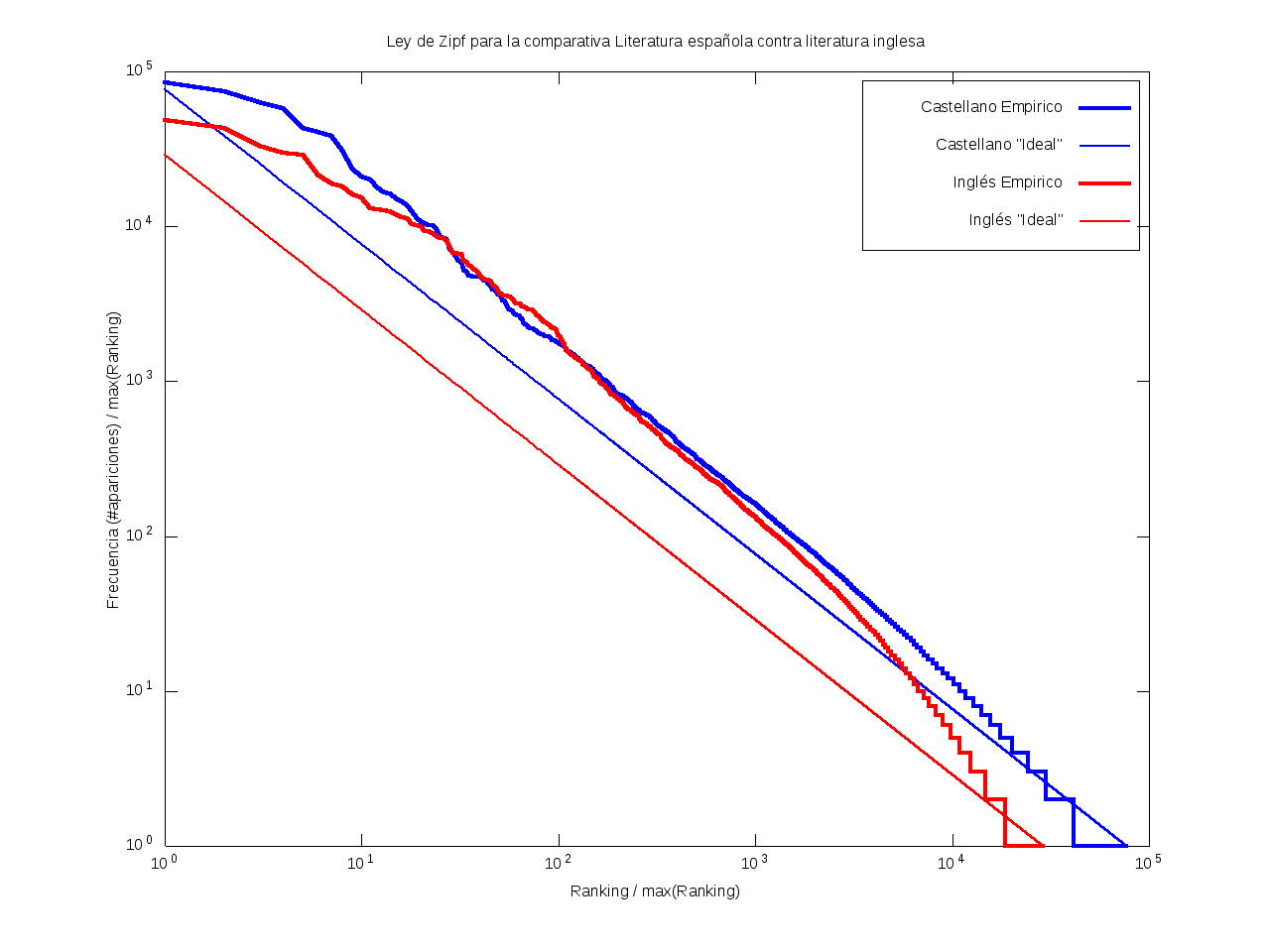

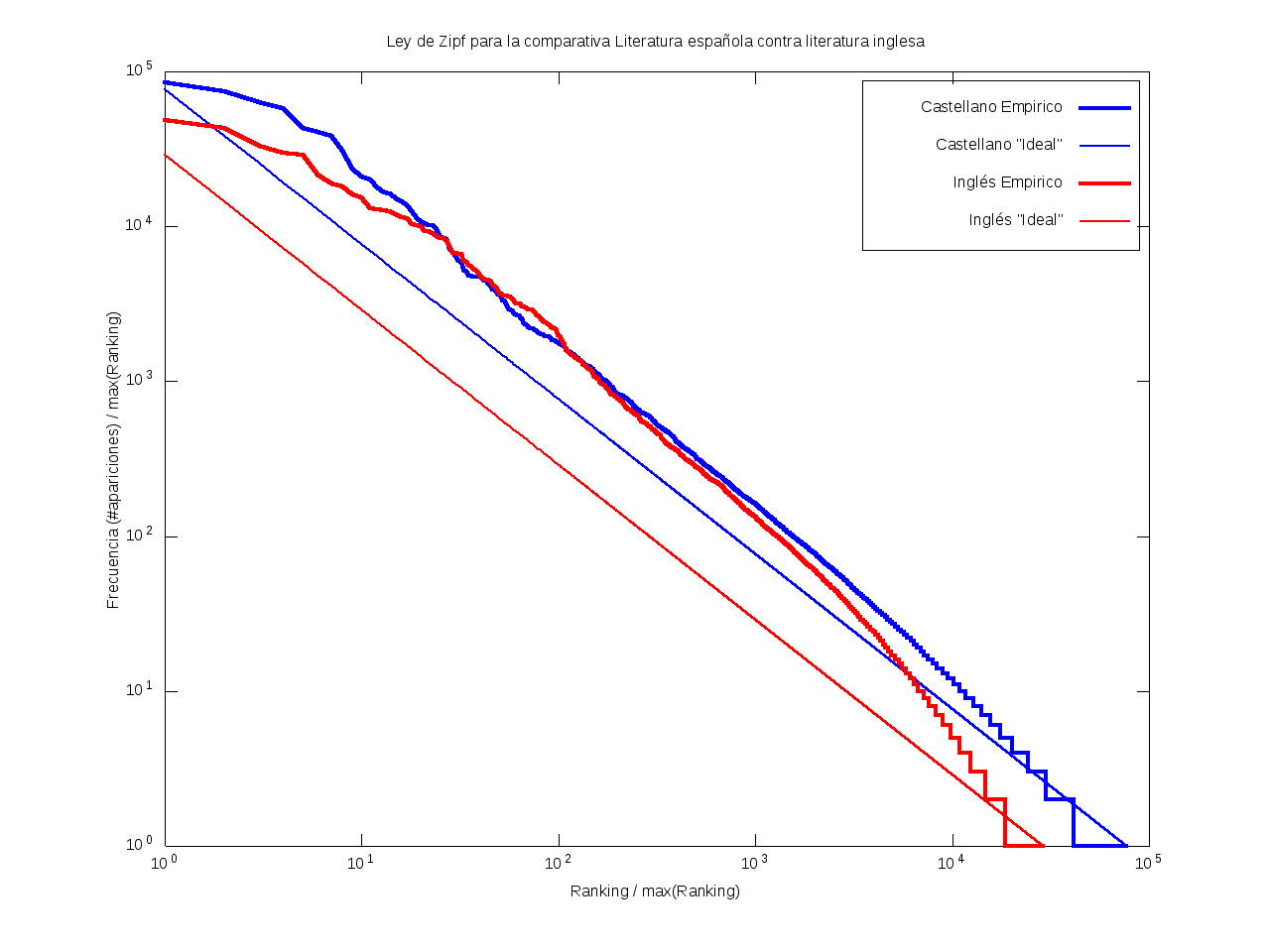

Ley de Zipf

La ley de Zipf es una ley empírica que se basa en el principio de mínimos esfuerzo.

Esto es, supone que existe un pequeño número de palabras, las más "conocidas", que son utilizadas con mucha frecuencia,

mientras que hay un gran número de palabras son poco empleadas.

Matemáticamente esto quiere decir que la frecuencia (número de apariciones) de una palabra cualquiera

es inversamente proporcional a su ranking,

entendido como su posición en una lista de las palabras presentes en el texto ordenada descendentemente en función de su frecuencia.

Así, la palabra más frecuente aparecerá aproximadamente dos veces más que la segunda palabra más frecuente,

unas tres veces más que la tercera palabra más frecuente, etc.

Gráficamente, cuando una curva se encuentra por encima de la recta "ideal"

quiere decir que el texto emplea recurrentemente un número de palabras muy reducido,

habiendo muy pocas que aparezcan con poca frecuencia.

Por el contrario, cuando la curva se encuentra por debajo de la "ideal",

el texto contiene un vocabulario más amplio, con muchas palabras que aparecen relativamente pocas veces.

| Castellano | Inglés |

Ilustración del principio de mínimo esfuerzo: |

| Rank | Palabra | Frec |

|---|

| 1 | de | 85641 |

| 2 | que | 74680 |

| 3 | y | 63032 |

| 4 | la | 58241 |

| 5 | a | 42958 |

| 6 | el | 40763 |

| 7 | en | 38512 |

| 8 | no | 30693 |

| 9 | se | 23495 |

| 10 | los | 21071 |

| 11 | con | 19945 |

| 12 | por | 17935 |

| 13 | las | 16539 |

| 14 | su | 16266 |

| 15 | lo | 15101 |

| 16 | un | 14496 |

| 17 | le | 13745 |

| 18 | del | 12449 |

| 19 | me | 11265 |

| 20 | es | 10752 |

| 21 | al | 10553 |

| 22 | una | 10216 |

| 23 | como | 10143 |

| 24 | más | 9589 |

| 25 | para | 8633 |

| 26 | si | 8463 |

| 27 | yo | 8220 |

| 28 | pero | 7155 |

| 29 | mi | 6800 |

| 30 | era | 6460 |

| 31 | había | 6030 |

| 32 | qué | 5858 |

| 33 | sus | 5244 |

| 34 | don | 5101 |

| 35 | él | 4823 |

| 36 | o | 4797 |

| 37 | sin | 4745 |

| 38 | dijo | 4739 |

| 39 | ya | 4738 |

| 40 | todo | 4713 |

| 41 | porque | 4609 |

| 42 | te | 4443 |

| 43 | ni | 4443 |

| 44 | tan | 4236 |

| 45 | usted | 4121 |

| 46 | bien | 3933 |

| 47 | ha | 3893 |

| 48 | ella | 3837 |

| 49 | pues | 3694 |

| 50 | cuando | 3603 |

| 51 | muy | 3555 |

| 52 | ser | 3315 |

| 53 | esto | 3306 |

| 54 | esta | 3178 |

| 55 | casa | 3019 |

| 56 | señor | 2901 |

| 57 | dos | 2901 |

| 58 | todos | 2884 |

| 59 | este | 2782 |

| 60 | e | 2695 |

| 61 | estaba | 2686 |

| 62 | aquel | 2680 |

| 63 | sí | 2661 |

| 64 | dios | 2600 |

| 65 | así | 2559 |

| 66 | sancho | 2414 |

| 67 | tu | 2378 |

| 68 | tenía | 2341 |

| 69 | aquella | 2291 |

| 70 | otra | 2236 |

| 71 | quien | 2221 |

| 72 | sobre | 2199 |

| 73 | quijote | 2198 |

| 74 | aquí | 2183 |

| 75 | hay | 2165 |

| 76 | poco | 2138 |

| 77 | otro | 2133 |

| 78 | he | 2114 |

| 79 | mí | 2083 |

| 80 | fue | 2038 |

| 81 | nos | 2023 |

| 82 | nada | 2017 |

| 83 | ver | 1997 |

| 84 | está | 1974 |

| 85 | hombre | 1952 |

| 86 | después | 1948 |

| 87 | mucho | 1947 |

| 88 | señora | 1946 |

| 89 | entre | 1942 |

| 90 | día | 1934 |

| 91 | vida | 1886 |

| 92 | donde | 1849 |

| 93 | decir | 1844 |

| 94 | tal | 1843 |

| 95 | cosa | 1841 |

| 96 | hasta | 1835 |

| 97 | mal | 1824 |

| 98 | tú | 1798 |

| 99 | son | 1782 |

| 100 | doña | 1754 |

| 101 | sino | 1728 |

| 102 | allí | 1727 |

| 103 | eso | 1725 |

| 104 | tiene | 1722 |

| 105 | é | 1704 |

| 106 | hacer | 1684 |

| 107 | cual | 1678 |

| 108 | también | 1650 |

| 109 | ahora | 1636 |

| 110 | mundo | 1587 |

| 111 | tiempo | 1564 |

| 112 | aunque | 1564 |

| 113 | todas | 1555 |

| 114 | ojos | 1549 |

| 115 | cosas | 1533 |

| 116 | gran | 1528 |

| 117 | tanto | 1525 |

| 118 | toda | 1497 |

| 119 | siempre | 1496 |

| 120 | mujer | 1469 |

| 121 | menos | 1465 |

| 122 | noche | 1435 |

| 123 | buen | 1429 |

| 124 | mismo | 1420 |

| 125 | les | 1418 |

| 126 | fin | 1413 |

| 127 | mas | 1385 |

| 128 | cómo | 1361 |

| 129 | vez | 1353 |

| 130 | mis | 1351 |

| 131 | verdad | 1344 |

| 132 | mano | 1332 |

| 133 | uno | 1318 |

| 134 | tengo | 1314 |

| 135 | algo | 1293 |

| 136 | mejor | 1284 |

| 137 | sé | 1282 |

| 138 | decía | 1269 |

| 139 | puede | 1265 |

| 140 | parte | 1263 |

| 141 | non | 1256 |

| 142 | luego | 1252 |

| 143 | d | 1249 |

| 144 | respondió | 1242 |

| 145 | buena | 1235 |

| 146 | cabeza | 1233 |

| 147 | dar | 1207 |

| 148 | dicho | 1202 |

| 149 | antes | 1192 |

| 150 | amor | 1192 |

| 151 | han | 1168 |

| 152 | alma | 1164 |

| 153 | eran | 1156 |

| 154 | desde | 1149 |

| 155 | soy | 1138 |

| 156 | hecho | 1134 |

| 157 | días | 1122 |

| 158 | otros | 1117 |

| 159 | iba | 1113 |

| 160 | estas | 1108 |

| 161 | podía | 1100 |

| 162 | fuera | 1100 |

| 163 | parece | 1077 |

| 164 | veces | 1072 |

| 165 | ellos | 1058 |

| 166 | quiero | 1053 |

| 167 | quién | 1041 |

| 168 | habían | 1028 |

| 169 | merced | 1027 |

| 170 | nunca | 1024 |

| 171 | vuestra | 1017 |

| 172 | tres | 1017 |

| 173 | sólo | 1016 |

| 174 | manos | 1008 |

| 175 | digo | 993 |

| 176 | cada | 993 |

| 177 | otras | 973 |

| 178 | madre | 973 |

| 179 | ana | 971 |

| 180 | visto | 967 |

| 181 | amigo | 966 |

| 182 | sea | 949 |

| 183 | alguna | 947 |

| 184 | voz | 940 |

| 185 | calle | 925 |

| 186 | ese | 919 |

| 187 | caballero | 919 |

| 188 | padre | 916 |

| 189 | parecía | 905 |

| 190 | os | 902 |

| 191 | estos | 874 |

| 192 | fortunata | 869 |

| 193 | á | 863 |

| 194 | tener | 855 |

| 195 | sido | 852 |

| 196 | años | 847 |

| 197 | manera | 835 |

| 198 | hizo | 832 |

| 199 | hacía | 830 |

| 200 | saber | 828 |

| 201 | tierra | 827 |

| 202 | hija | 824 |

| 203 | cuanto | 823 |

| 204 | puerta | 819 |

| 205 | va | 818 |

| 206 | esa | 817 |

| 207 | quiere | 813 |

| 208 | quería | 813 |

| 209 | pobre | 812 |

| 210 | sabe | 809 |

| 211 | hace | 804 |

| 212 | mañana | 801 |

| 213 | hijo | 797 |

| 214 | entonces | 797 |

| 215 | muchos | 796 |

| 216 | has | 796 |

| 217 | muchas | 788 |

| 218 | dice | 786 |

| 219 | dio | 781 |

| 220 | mayor | 780 |

| 221 | nadie | 777 |

| 222 | magistral | 775 |

| 223 | cielo | 771 |

| 224 | modo | 766 |

| 225 | grande | 765 |

| 226 | aquellos | 763 |

| 227 | algún | 758 |

| 228 | amo | 754 |

| 229 | haber | 745 |

| 230 | santa | 743 |

| 231 | cuerpo | 743 |

| 232 | palabras | 741 |

| 233 | allá | 735 |

| 234 | vio | 733 |

| 235 | camino | 731 |

| 236 | puesto | 726 |

| 237 | estoy | 719 |

| 238 | medio | 701 |

| 239 | cara | 695 |

| 240 | rey | 694 |

| 241 | muerte | 694 |

| 242 | sabía | 688 |

| 243 | ti | 687 |

| 244 | bueno | 683 |

| 245 | lugar | 680 |

| 246 | unos | 675 |

| 247 | mil | 672 |

| 248 | ay | 665 |

| 249 | vos | 663 |

| 250 | tarde | 662 |

| 251 | punto | 661 |

| 252 | hombres | 661 |

| 253 | hora | 659 |

| 254 | oh | 655 |

| 255 | hablar | 654 |

| 256 | boca | 652 |

| 257 | diciendo | 648 |

| 258 | palabra | 645 |

| 259 | daba | 645 |

| 260 | aun | 639 |

| 261 | primero | 637 |

| 262 | gente | 631 |

| 263 | caso | 630 |

| 264 | ir | 629 |

| 265 | será | 628 |

| 266 | contra | 628 |

| 267 | salir | 625 |

| 268 | corazón | 625 |

| 269 | cuatro | 623 |

| 270 | según | 620 |

| 271 | dentro | 620 |

| 272 | casi | 620 |

| 273 | marido | 617 |

| 274 | algunos | 617 |

| 275 | pie | 615 |

| 276 | misma | 615 |

| 277 | mala | 613 |

| 278 | estar | 613 |

| 279 | aquello | 610 |

| 280 | persona | 609 |

| 281 | da | 608 |

| 282 | estaban | 607 |

| 283 | nuestro | 604 |

| 284 | puso | 603 |

| 285 | mío | 603 |

| 286 | cura | 603 |

| 287 | hoy | 602 |

| 288 | cierto | 601 |

| 289 | cuenta | 600 |

| 290 | grandes | 593 |

| 291 | demás | 591 |

| 292 | hubiera | 588 |

| 293 | nombre | 585 |

| 294 | dado | 582 |

| 295 | mucha | 580 |

| 296 | idea | 579 |

| 297 | jacinta | 571 |

| 298 | volvió | 570 |

| 299 | tus | 562 |

| 300 | mía | 562 |

| 301 | creo | 560 |

| 302 | vino | 558 |

| 303 | juan | 556 |

| 304 | martín | 555 |

| 305 | razón | 551 |

| 306 | duda | 551 |

| 307 | pronto | 549 |

| 308 | fuerza | 549 |

| 309 | agua | 547 |

| 310 | ellas | 544 |

| 311 | nuestra | 540 |

| 312 | pueblo | 537 |

| 313 | luz | 535 |

| 314 | comer | 532 |

| 315 | gusto | 528 |

| 316 | aquellas | 525 |

| 317 | vamos | 524 |

| 318 | llegó | 522 |

| 319 | lupe | 521 |

| 320 | hacia | 521 |

| 321 | paso | 518 |

| 322 | eres | 515 |

| 323 | solo | 514 |

| 324 | voy | 513 |

| 325 | mientras | 513 |

| 326 | fuese | 513 |

| 327 | dónde | 512 |

| 328 | álvaro | 512 |

| 329 | historia | 507 |

| 330 | lado | 504 |

| 331 | tuvo | 503 |

| 332 | tienes | 502 |

| 333 | delante | 502 |

| 334 | debe | 501 |

| 335 | víctor | 498 |

| 336 | puedo | 498 |

| 337 | miedo | 498 |

| 338 | dinero | 496 |

| 339 | entró | 492 |

| 340 | pudo | 491 |

| 341 | pasar | 490 |

| 342 | suelo | 488 |

| 343 | unas | 486 |

| 344 | estado | 486 |

| 345 | entrar | 485 |

| 346 | algunas | 484 |

| 347 | poder | 483 |

| 348 | pies | 482 |

| 349 | tanta | 481 |

| 350 | regenta | 481 |

| 351 | triste | 478 |

| 352 | viene | 475 |

| 353 | falta | 473 |

| 354 | vetusta | 472 |

| 355 | momento | 472 |

| 356 | están | 472 |

| 357 | san | 471 |

| 358 | debía | 471 |

| 359 | vista | 470 |

| 360 | nuevo | 470 |

| 361 | tales | 467 |

| 362 | señores | 466 |

| 363 | sería | 464 |

| 364 | preguntó | 464 |

| 365 | joven | 464 |

| 366 | salió | 463 |

| 367 | amigos | 462 |

| 368 | rostro | 461 |

| 369 | ninguna | 461 |

| 370 | pensaba | 456 |

| 371 | nosotros | 455 |

| 372 | vaya | 452 |

| 373 | sol | 452 |

| 374 | primera | 452 |

| 375 | replicó | 449 |

| 376 | quiso | 449 |

| 377 | mira | 446 |

| 378 | adelante | 445 |

| 379 | fueron | 443 |

| 380 | aún | 440 |

| 381 | viendo | 439 |

| 382 | venía | 439 |

| 383 | hermano | 438 |

| 384 | ello | 437 |

| 385 | dando | 434 |

| 386 | sola | 431 |

| 387 | madrid | 431 |

| 388 | tomar | 429 |

| 389 | dicen | 422 |

| 390 | sabes | 420 |

| 391 | tienen | 419 |

| 392 | brazos | 419 |

| 393 | agora | 412 |

| 394 | poner | 410 |

| 395 | mar | 410 |

| 396 | cruz | 409 |

| 397 | quedó | 407 |

| 398 | horas | 407 |

| 399 | mesa | 406 |

| 400 | fuerte | 406 |

| 401 | fué | 405 |

| 402 | cerca | 405 |

| 403 | personas | 404 |

| 404 | media | 403 |

| 405 | causa | 403 |

| 406 | ante | 403 |

| 407 | pena | 397 |

| 408 | mujeres | 397 |

| 409 | además | 397 |

| 410 | oro | 395 |

| 411 | junto | 395 |

| 412 | veía | 394 |

| 413 | oído | 394 |

| 414 | caballeros | 393 |

| 415 | voluntad | 391 |

| 416 | todavía | 391 |

| 417 | tía | 391 |

| 418 | hermosa | 391 |

| 419 | buenas | 391 |

| 420 | trabajo | 384 |

| 421 | pasado | 384 |

| 422 | vieja | 381 |

| 423 | viejo | 379 |

| 424 | veo | 379 |

| 425 | venir | 379 |

| 426 | jamás | 379 |

| 427 | fuego | 379 |

| 428 | aire | 379 |

| 429 | volver | 378 |

| 430 | fe | 376 |

| 431 | esas | 376 |

| 432 | ideas | 375 |

| 433 | sangre | 373 |

| 434 | mesía | 373 |

| 435 | ah | 373 |

| 436 | apenas | 371 |

| 437 | llegar | 370 |

| 438 | deseo | 370 |

| 439 | posible | 369 |

| 440 | cuarto | 369 |

| 441 | vi | 367 |

| 442 | amiga | 367 |

| 443 | sentía | 366 |

| 444 | pensar | 366 |

| 445 | quieres | 365 |

| 446 | caballo | 365 |

| 447 | tenían | 364 |

| 448 | memoria | 364 |

| 449 | libro | 363 |

| 450 | suerte | 362 |

| 451 | dolor | 362 |

| 452 | desta | 362 |

| 453 | iglesia | 361 |

| 454 | familia | 361 |

| 455 | ahí | 359 |

| 456 | estás | 358 |

| 457 | año | 356 |

| 458 | muerto | 354 |

| 459 | fermín | 354 |

| 460 | pasó | 353 |

| 461 | vivir | 351 |

| 462 | razones | 351 |

| 463 | pesar | 351 |

| 464 | lengua | 351 |

| 465 | haciendo | 351 |

| 466 | espíritu | 351 |

| 467 | dije | 350 |

| 468 | parecer | 349 |

| 469 | obra | 349 |

| 470 | tantas | 348 |

| 471 | esos | 348 |

| 472 | éste | 347 |

| 473 | claro | 347 |

| 474 | rato | 346 |

| 475 | pasaba | 346 |

| 476 | orden | 346 |

| 477 | ve | 345 |

| 478 | diez | 345 |

| 479 | tras | 344 |

| 480 | remedio | 342 |

| 481 | nela | 341 |

| 482 | alto | 340 |

| 483 | panza | 339 |

| 484 | hubo | 339 |

| 485 | gracias | 339 |

| 486 | sintió | 337 |

| 487 | loco | 337 |

| 488 | buenos | 337 |

| 489 | silencio | 336 |

| 490 | creía | 336 |

| 491 | valor | 334 |

| 492 | pensamiento | 334 |

| 493 | hermosura | 333 |

| 494 | alguno | 333 |

| 495 | exclamó | 325 |

| 496 | conmigo | 325 |

| 497 | guillermina | 324 |

| 498 | brazo | 324 |

| 499 | nueva | 322 |

| 500 | niña | 322 |

| 501 | lejos | 322 |

| 502 | ido | 321 |

| 503 | cama | 319 |

| 504 | dejar | 318 |

| 505 | pudiera | 316 |

| 506 | hablaba | 316 |

| 507 | voces | 315 |

| 508 | podría | 315 |

| 509 | pecho | 315 |

| 510 | ocasión | 315 |

| 511 | dejó | 315 |

| 512 | rubín | 314 |

| 513 | libros | 314 |

| 514 | tantos | 313 |

| 515 | lágrimas | 313 |

| 516 | entender | 313 |

| 517 | benina | 313 |

| 518 | tenido | 311 |

| 519 | ama | 310 |

| 520 | quintanar | 309 |

| 521 | llama | 309 |

| 522 | siendo | 308 |

| 523 | nuño | 308 |

| 524 | hijos | 308 |

| 525 | estuvo | 308 |

| 526 | primer | 307 |

| 527 | oír | 307 |

| 528 | campo | 307 |

| 529 | natural | 305 |

| 530 | hemos | 305 |

| 531 | arriba | 305 |

| 532 | maxi | 304 |

| 533 | figura | 304 |

| 534 | cuales | 303 |

| 535 | gracia | 302 |

| 536 | armas | 301 |

| 537 | iban | 299 |

| 538 | edad | 299 |

| 539 | suyo | 298 |

| 540 | querer | 297 |

| 541 | partes | 297 |

| 542 | general | 297 |

| 543 | maximiliano | 295 |

| 544 | instante | 295 |

| 545 | frente | 295 |

| 546 | pan | 293 |

| 547 | seis | 292 |

| 548 | nuestros | 292 |

| 549 | mitad | 292 |

| 550 | ustedes | 291 |

| 551 | preciso | 290 |

| 552 | dulce | 290 |

| 553 | papel | 289 |

| 554 | llamaba | 289 |

| 555 | debajo | 289 |

| 556 | conciencia | 289 |

| 557 | vuestro | 288 |

| 558 | llevar | 288 |

| 559 | hacen | 287 |

| 560 | cabo | 287 |

| 561 | mirando | 286 |

| 562 | carlos | 285 |

| 563 | ciudad | 284 |

| 564 | sueño | 283 |

| 565 | dulcinea | 283 |

| 566 | abajo | 283 |

| 567 | ruido | 282 |

| 568 | obdulia | 282 |

| 569 | haya | 282 |

| 570 | cuidado | 282 |

| 571 | ciego | 282 |

| 572 | niño | 281 |

| 573 | cuya | 281 |

| 574 | creer | 280 |

| 575 | cel | 280 |

| 576 | carta | 280 |

| 577 | quisiera | 279 |

| 578 | ninguno | 279 |

| 579 | negro | 279 |

| 580 | llevaba | 279 |

| 581 | buscar | 279 |

| 582 | sr | 278 |

| 583 | andar | 277 |

| 584 | libre | 275 |

| 585 | santo | 274 |

| 586 | peor | 274 |

| 587 | pasos | 274 |

| 588 | fama | 274 |

| 589 | chico | 274 |

| 590 | tampoco | 273 |

| 591 | cinco | 273 |

| 592 | alegría | 273 |

| 593 | virtud | 272 |

| 594 | pepe | 272 |

| 595 | venido | 271 |

| 596 | seguro | 271 |

| 597 | ningún | 271 |

| 598 | suya | 270 |

| 599 | quiera | 268 |

| 600 | van | 267 |

| 601 | fortuna | 267 |

| 602 | españa | 267 |

| 603 | dan | 266 |

| 604 | contento | 266 |

| 605 | mozo | 265 |

| 606 | sala | 264 |

| 607 | querido | 264 |

| 608 | guerra | 264 |

| 609 | señoras | 263 |

| 610 | efecto | 263 |

| 611 | ropa | 262 |

| 612 | casas | 262 |

| 613 | caer | 262 |

| 614 | bajo | 262 |

| 615 | traía | 261 |

| 616 | quando | 261 |

| 617 | maría | 261 |

| 618 | malo | 261 |

| 619 | cualquier | 261 |

| 620 | pueden | 260 |

| 621 | pasa | 260 |

| 622 | largo | 260 |

| 623 | escudero | 260 |

| 624 | ven | 259 |

| 625 | culpa | 259 |

| 626 | paz | 258 |

| 627 | miraba | 258 |

| 628 | gloria | 258 |

| 629 | ventura | 257 |

| 630 | petra | 257 |

| 631 | mirar | 257 |

| 632 | llaman | 257 |

| 633 | gana | 257 |

| 634 | peligro | 256 |

| 635 | diablo | 256 |

| 636 | habría | 255 |

| 637 | encima | 254 |

| 638 | visita | 253 |

| 639 | siguiente | 253 |

| 640 | reales | 252 |

| 641 | ponía | 252 |

| 642 | viento | 250 |

| 643 | tomó | 249 |

| 644 | nin | 249 |

| 645 | añadió | 249 |

| 646 | tenga | 248 |

| 647 | gobierno | 248 |

| 648 | di | 248 |

| 649 | anda | 248 |

| 650 | alegre | 248 |

| 651 | último | 247 |

| 652 | perder | 247 |

| 653 | habrá | 247 |

| 654 | conversación | 247 |

| 655 | pedro | 246 |

| 656 | menester | 246 |

| 657 | hermana | 246 |

| 658 | coche | 246 |

| 659 | hambre | 245 |

| 660 | gobernador | 245 |

| 661 | doncella | 245 |

| 662 | propio | 244 |

| 663 | bastante | 244 |

| 664 | sentido | 243 |

| 665 | perdido | 243 |

| 666 | pareció | 243 |

| 667 | mesmo | 243 |

| 668 | comenzó | 243 |

| 669 | justicia | 242 |

| 670 | alta | 242 |

| 671 | esposa | 241 |

| 672 | enemigo | 241 |

| 673 | criado | 241 |

| 674 | siquiera | 240 |

| 675 | segunda | 240 |

| 676 | principio | 240 |

| 677 | ésta | 240 |

| 678 | detrás | 240 |

| 679 | cal | 239 |

| 680 | salud | 237 |

| 681 | pensó | 237 |

| 682 | pablo | 237 |

| 683 | derecho | 237 |

| 684 | cierta | 237 |

| 685 | pensamientos | 236 |

| 686 | perfecta | 235 |

| 687 | duque | 235 |

| 688 | dueña | 235 |

| 689 | color | 235 |

| 690 | deste | 234 |

| 691 | sale | 233 |

| 692 | libertad | 233 |

| 693 | vuesa | 232 |

| 694 | vuelta | 232 |

| 695 | espada | 232 |

| 696 | darle | 232 |

| 697 | carne | 232 |

| 698 | pobres | 231 |

| 699 | miró | 231 |

| 700 | cuyo | 231 |

| 701 | blanco | 231 |

| 702 | vestido | 230 |

| 703 | estamos | 230 |

| 704 | poca | 229 |

| 705 | haga | 229 |

| 706 | arte | 229 |

| 707 | risa | 228 |

| 708 | padres | 228 |

| 709 | habla | 228 |

| 710 | plaza | 227 |

| 711 | morir | 227 |

| 712 | pienso | 226 |

| 713 | oficio | 226 |

| 714 | hablando | 226 |

| 715 | dieron | 226 |

| 716 | verdadero | 224 |

| 717 | pocos | 224 |

| 718 | dama | 224 |

| 719 | v | 223 |

| 720 | sociedad | 223 |

| 721 | rico | 223 |

| 722 | josé | 223 |

| 723 | dormir | 223 |

| 724 | dejaba | 223 |

| 725 | tenemos | 222 |

| 726 | capítulo | 222 |

| 727 | pueda | 221 |

| 728 | presencia | 221 |

| 729 | diga | 221 |

| 730 | sobrino | 220 |

| 731 | segundo | 220 |

| 732 | naturaleza | 220 |

| 733 | grand | 220 |

| 734 | dé | 220 |

| 735 | salía | 219 |

| 736 | labios | 219 |

| 737 | frío | 219 |

| 738 | venga | 218 |

| 739 | nuevas | 218 |

| 740 | llegado | 218 |

| 741 | doce | 218 |

| 742 | honor | 217 |

| 743 | desgracia | 217 |

| 744 | tío | 216 |

| 745 | temor | 216 |

| 746 | principal | 216 |

| 747 | leer | 216 |

| 748 | acá | 216 |

| 749 | tono | 215 |

| 750 | basta | 215 |

| 751 | ves | 214 |

| 752 | propia | 214 |

| 753 | piedra | 214 |

| 754 | ánimo | 214 |

| 755 | oyó | 213 |

| 756 | ocho | 213 |

| 757 | semp | 212 |

| 758 | presto | 211 |

| 759 | presente | 211 |

| 760 | par | 211 |

| 761 | lástima | 211 |

| 762 | frígilis | 211 |

| 763 | sombra | 210 |

| 764 | pedir | 210 |

| 765 | acaso | 210 |

| 766 | público | 209 |

| 767 | obras | 209 |

| 768 | queda | 208 |

| 769 | esperanza | 208 |

| 770 | atención | 208 |

| 771 | teatro | 207 |

| 772 | señorita | 207 |

| 773 | pensando | 207 |

| 774 | rocinante | 206 |

| 775 | costumbre | 206 |

| 776 | tristeza | 205 |

| 777 | noble | 205 |

| 778 | dél | 205 |

| 779 | contestó | 205 |

| 780 | pocas | 204 |

| 781 | noches | 204 |

| 782 | diré | 204 |

| 783 | solía | 203 |

| 784 | lleno | 203 |

| 785 | compañía | 203 |

| 786 | andante | 203 |

| 787 | vea | 202 |

| 788 | real | 202 |

| 789 | gritó | 202 |

| 790 | tiempos | 201 |

| 791 | sacar | 201 |

| 792 | marqués | 201 |

| 793 | echar | 201 |

| 794 | amores | 201 |

| 795 | llamar | 200 |

| 796 | blanca | 200 |

| 797 | bautista | 200 |

| 798 | ayer | 200 |

| 799 | santos | 199 |

| 800 | meses | 199 |

| 801 | duquesa | 199 |

| 802 | canónigo | 199 |

| 803 | virgen | 198 |

| 804 | mancha | 198 |

| 805 | intención | 198 |

| 806 | dedos | 198 |

| 807 | contar | 198 |

| 808 | vergüenza | 197 |

| 809 | flores | 197 |

| 810 | della | 197 |

| 811 | autor | 197 |

| 812 | quieren | 196 |

| 813 | parecían | 196 |

| 814 | vn | 195 |

| 815 | verde | 195 |

| 816 | único | 195 |

| 817 | llena | 195 |

| 818 | cuantos | 195 |

| 819 | país | 194 |

| 820 | nuestras | 194 |

| 821 | podrá | 193 |

| 822 | narv | 193 |

| 823 | fernando | 193 |

| 824 | secreto | 192 |

| 825 | moreno | 192 |

| 826 | mauricia | 192 |

| 827 | importa | 192 |

| 828 | esposo | 192 |

| 829 | café | 192 |

| 830 | senora | 191 |

| 831 | durante | 191 |

| 832 | anita | 191 |

| 833 | volvía | 190 |

| 834 | vivo | 190 |

| 835 | imposible | 190 |

| 836 | honra | 190 |

| 837 | correr | 190 |

| 838 | barbarita | 190 |

| 839 | semejante | 189 |

| 840 | pecado | 189 |

| 841 | juicio | 189 |

| 842 | decían | 189 |

| 843 | sitio | 188 |

| 844 | silla | 188 |

| 845 | quanto | 188 |

| 846 | oía | 188 |

| 847 | chica | 188 |

| 848 | baja | 188 |

| 849 | río | 187 |

| 850 | piedad | 187 |

| 851 | mayores | 187 |

| 852 | mandó | 187 |

| 853 | veinte | 186 |

| 854 | empezó | 186 |

| 855 | criada | 186 |

| 856 | camila | 186 |

| 857 | calles | 186 |

| 858 | atrás | 186 |

| 859 | respeto | 185 |

| 860 | balcón | 185 |

| 861 | escalera | 184 |

| 862 | contrario | 184 |

| 863 | vale | 183 |

| 864 | toma | 183 |

| 865 | subir | 183 |

| 866 | opinión | 183 |

| 867 | médico | 183 |

| 868 | hago | 183 |

| 869 | forma | 183 |

| 870 | estando | 183 |

| 871 | echó | 183 |

| 872 | do | 183 |

| 873 | criados | 183 |

| 874 | vive | 182 |

| 875 | suele | 182 |

| 876 | escribir | 182 |

| 877 | entendimiento | 182 |

| 878 | pelayo | 181 |

| 879 | noticia | 181 |

| 880 | finalmente | 181 |

| 881 | veras | 180 |

| 882 | matar | 180 |

| 883 | ley | 180 |

| 884 | imaginación | 180 |

| 885 | favor | 180 |

| 886 | deja | 180 |

| 887 | conozco | 180 |

| 888 | barbero | 180 |

| 889 | venían | 179 |

| 890 | somos | 179 |

| 891 | puedes | 179 |

| 892 | necesidad | 179 |

| 893 | entraba | 179 |

| 894 | deseos | 179 |

| 895 | amistad | 179 |

| 896 | tienda | 178 |

| 897 | sobrina | 178 |

| 898 | podían | 178 |

| 899 | paseo | 178 |

| 900 | letras | 178 |

| 901 | cuento | 178 |

| 902 | aventura | 178 |

| 903 | vuelto | 177 |

| 904 | cualquiera | 177 |

| 905 | consejo | 177 |

| 906 | ansí | 177 |

| 907 | pone | 176 |

| 908 | paco | 176 |

| 909 | grave | 176 |

| 910 | duro | 176 |

| 911 | venta | 175 |

| 912 | querida | 175 |

| 913 | juntos | 175 |

| 914 | embargo | 175 |

| 915 | cocina | 175 |

| 916 | asno | 175 |

| 917 | verás | 174 |

| 918 | paula | 174 |

| 919 | pas | 174 |

| 920 | llegaba | 174 |

| 921 | hacían | 174 |

| 922 | fondo | 174 |

| 923 | dices | 174 |

| 924 | cuello | 174 |

| 925 | anselmo | 174 |

| 926 | alcoba | 174 |

| 927 | verle | 173 |

| 928 | pasión | 173 |

| 929 | paciencia | 173 |

| 930 | lleva | 173 |

| 931 | izquierdo | 173 |

| 932 | religión | 172 |

| 933 | esperar | 172 |

| 934 | decirle | 172 |

| 935 | vas | 171 |

| 936 | servir | 171 |

| 937 | quedaba | 171 |

| 938 | locura | 171 |

| 939 | hicieron | 171 |

| 940 | daban | 171 |

| 941 | primo | 170 |

| 942 | malos | 170 |

| 943 | lecho | 170 |

| 944 | l | 170 |

| 945 | haré | 170 |

| 946 | dientes | 170 |

| 947 | dejando | 170 |

| 948 | batalla | 170 |

| 949 | assi | 170 |

| 950 | viva | 169 |

| 951 | verdadera | 169 |

| 952 | marquesa | 169 |

| 953 | cristiano | 169 |

| 954 | supo | 168 |

| 955 | sombrero | 168 |

| 956 | expresión | 168 |

| 957 | castillo | 168 |

| 958 | sacó | 167 |

| 959 | negra | 167 |

| 960 | habéis | 167 |

| 961 | esperaba | 167 |

| 962 | cuánto | 167 |

| 963 | aventuras | 167 |

| 964 | tuviera | 166 |

| 965 | siento | 166 |

| 966 | seguía | 166 |

| 967 | puertas | 166 |

| 968 | perro | 166 |

| 969 | malas | 166 |

| 970 | infeliz | 166 |

| 971 | fuerzas | 166 |

| 972 | enfermo | 166 |

| 973 | cuál | 166 |

| 974 | verla | 165 |

| 975 | traje | 165 |

| 976 | ome | 165 |

| 977 | llorar | 165 |

| 978 | doy | 165 |

| 979 | dejado | 165 |

| 980 | contigo | 165 |

| 981 | propósito | 164 |

| 982 | obispo | 164 |

| 983 | hechos | 164 |

| 984 | enemigos | 164 |

| 985 | árboles | 164 |

| 986 | toboso | 163 |

| 987 | siete | 163 |

| 988 | señal | 163 |

| 989 | mire | 163 |

| 990 | espacio | 163 |

| 991 | enamorado | 163 |

| 992 | corte | 163 |

| 993 | conocía | 163 |

| 994 | catedral | 163 |

| 995 | negocio | 162 |

| 996 | daño | 162 |

| 997 | andantes | 162 |

| 998 | andaba | 162 |

| 999 | adonde | 162 |

| 1000 | versos | 161 |

| 1001 | siguió | 161 |

| 1002 | sentir | 161 |

| 1003 | sean | 161 |

| 1004 | salido | 161 |

| 1005 | sabio | 161 |

| 1006 | puro | 161 |

| 1007 | parm | 161 |

| 1008 | llevó | 161 |

| 1009 | jarifa | 161 |

| 1010 | derecha | 161 |

| 1011 | ángel | 161 |

| 1012 | viuda | 160 |

| 1013 | habló | 160 |

| 1014 | conocer | 160 |

| 1015 | confianza | 160 |

| 1016 | calisto | 160 |

| 1017 | sepa | 159 |

| 1018 | repente | 159 |

| 1019 | loca | 159 |

| 1020 | llegaron | 159 |

| 1021 | levantó | 159 |

| 1022 | habiendo | 159 |

| 1023 | creyó | 159 |

| 1024 | verá | 158 |

| 1025 | siglo | 158 |

| 1026 | mes | 158 |

| 1027 | larga | 158 |

| 1028 | género | 158 |

| 1029 | conocido | 158 |

| 1030 | cargo | 158 |

| 1031 | caballería | 158 |

| 1032 | terrible | 157 |

| 1033 | ojo | 156 |

| 1034 | moral | 156 |

| 1035 | mirada | 156 |

| 1036 | famoso | 156 |

| 1037 | demasiado | 156 |

| 1038 | sy | 155 |

| 1039 | provisor | 155 |

| 1040 | plata | 155 |

| 1041 | piernas | 155 |

| 1042 | fácil | 155 |

| 1043 | clase | 155 |

| 1044 | vivía | 154 |

| 1045 | rosario | 154 |

| 1046 | moro | 154 |

| 1047 | mamá | 154 |

| 1048 | juego | 154 |

| 1049 | grado | 154 |

| 1050 | capa | 154 |

| 1051 | vienen | 153 |

| 1052 | senor | 153 |

| 1053 | seguir | 153 |

| 1054 | poeta | 153 |

| 1055 | calor | 153 |

| 1056 | valiente | 152 |

| 1057 | luna | 152 |

| 1058 | hierro | 152 |

| 1059 | cerebro | 152 |

| 1060 | caridad | 152 |

| 1061 | ventana | 151 |

| 1062 | golpe | 151 |

| 1063 | ciertas | 151 |

| 1064 | cien | 151 |

| 1065 | belleza | 151 |

| 1066 | trae | 150 |

| 1067 | qual | 150 |

| 1068 | preciosa | 150 |

| 1069 | placer | 150 |

| 1070 | fueran | 150 |

| 1071 | damas | 150 |

| 1072 | curiosidad | 150 |

| 1073 | consigo | 150 |

| 1074 | busca | 150 |

| 1075 | acuerdo | 150 |

| 1076 | viaje | 149 |

| 1077 | oye | 149 |

| 1078 | melibea | 149 |

| 1079 | león | 149 |

| 1080 | cree | 149 |

| 1081 | condición | 149 |

| 1082 | suceso | 148 |

| 1083 | sentimiento | 148 |

| 1084 | niños | 148 |

| 1085 | mejores | 148 |

| 1086 | huésped | 148 |

| 1087 | hablado | 148 |

| 1088 | ambos | 148 |

| 1089 | dime | 147 |

| 1090 | cayó | 147 |

| 1091 | teresa | 146 |

| 1092 | servicio | 146 |

| 1093 | música | 146 |

| 1094 | mentira | 146 |

| 1095 | hermoso | 146 |

| 1096 | entra | 146 |

| 1097 | pura | 145 |

| 1098 | pelo | 145 |

| 1099 | dueño | 145 |

| 1100 | debo | 145 |

| 1101 | abind | 145 |

| 1102 | vna | 144 |

| 1103 | paca | 144 |

| 1104 | oyendo | 144 |

| 1105 | hombros | 144 |

| 1106 | ejemplo | 144 |

| 1107 | dura | 144 |

| 1108 | carrera | 144 |

| 1109 | podido | 143 |

| 1110 | monte | 143 |

| 1111 | miserable | 143 |

| 1112 | misa | 143 |

| 1113 | llamado | 143 |

| 1114 | faltaba | 143 |

| 1115 | espaldas | 143 |

| 1116 | casino | 143 |

| 1117 | segura | 142 |

| 1118 | saben | 142 |

| 1119 | rodillas | 142 |

| 1120 | ponerse | 142 |

| 1121 | muger | 142 |

| 1122 | lotario | 142 |

| 1123 | leído | 142 |

| 1124 | hubiese | 142 |

| 1125 | gabinete | 142 |

| 1126 | especie | 142 |

| 1127 | dellos | 142 |

| 1128 | abrió | 142 |

| 1129 | solos | 141 |

| 1130 | semejantes | 141 |

| 1131 | quizás | 141 |

| 1132 | licencia | 141 |

| 1133 | comedia | 141 |

| 1134 | clérigo | 141 |

| 1135 | cariño | 141 |

| 1136 | breve | 141 |

| 1137 | trato | 140 |

| 1138 | nicolás | 140 |

| 1139 | diz | 140 |

| 1140 | diciéndole | 140 |

| 1141 | celestina | 140 |

| 1142 | aposento | 140 |

| 1143 | acabó | 140 |

| 1144 | posada | 139 |

| 1145 | poniendo | 139 |

| 1146 | piedras | 139 |

| 1147 | comida | 139 |

| 1148 | ciencia | 139 |

| 1149 | bondad | 139 |

| 1150 | vieron | 138 |

| 1151 | suelen | 138 |

| 1152 | provecho | 138 |

| 1153 | muerta | 138 |

| 1154 | justo | 138 |

| 1155 | jesús | 138 |

| 1156 | disparates | 138 |

| 1157 | costumbres | 138 |

| 1158 | realidad | 137 |

| 1159 | interés | 137 |

| 1160 | hice | 137 |

| 1161 | comedor | 137 |

| 1162 | vueltas | 136 |

| 1163 | solas | 136 |

| 1164 | número | 136 |

| 1165 | manda | 136 |

| 1166 | estilo | 136 |

| 1167 | entiendo | 136 |

| 1168 | encontró | 136 |

| 1169 | conoce | 136 |

| 1170 | treinta | 135 |

| 1171 | situación | 135 |

| 1172 | sempronio | 135 |

| 1173 | orbajosa | 135 |

| 1174 | huerta | 135 |

| 1175 | encontraba | 135 |

| 1176 | reír | 134 |

| 1177 | humor | 134 |

| 1178 | humana | 134 |

| 1179 | gusta | 134 |

| 1180 | grandeza | 134 |

| 1181 | dicha | 134 |

| 1182 | byen | 134 |

| 1183 | ballester | 134 |

| 1184 | asunto | 134 |

| 1185 | antonio | 134 |

| 1186 | vuestras | 133 |

| 1187 | última | 133 |

| 1188 | traer | 133 |

| 1189 | toca | 133 |

| 1190 | talento | 133 |

| 1191 | oídos | 133 |

| 1192 | miseria | 133 |

| 1193 | discreto | 133 |

| 1194 | dió | 133 |

| 1195 | caído | 133 |

| 1196 | buscando | 133 |

| 1197 | vuelve | 132 |

| 1198 | vegallana | 132 |

| 1199 | prosiguió | 132 |

| 1200 | prisa | 132 |

| 1201 | objeto | 132 |

| 1202 | nacido | 132 |

| 1203 | leyes | 132 |

| 1204 | ira | 132 |

| 1205 | hacienda | 132 |

| 1206 | escrito | 132 |

| 1207 | cuán | 132 |

| 1208 | verse | 131 |

| 1209 | trataba | 131 |

| 1210 | subió | 131 |

| 1211 | ponte | 131 |

| 1212 | pañuelo | 131 |

| 1213 | movimiento | 131 |

| 1214 | duros | 131 |

| 1215 | carácter | 131 |

| 1216 | alcalde | 131 |

| 1217 | ronzal | 130 |

| 1218 | igual | 130 |

| 1219 | hecha | 130 |

| 1220 | banco | 130 |

| 1221 | varias | 129 |

| 1222 | soledad | 129 |

| 1223 | señas | 129 |

| 1224 | quitar | 129 |

| 1225 | patio | 129 |

| 1226 | navío | 129 |

| 1227 | miradas | 129 |

| 1228 | llevado | 129 |

| 1229 | gentes | 129 |

| 1230 | firme | 129 |

| 1231 | amante | 129 |

| 1232 | vestidos | 128 |

| 1233 | tomado | 128 |

| 1234 | reino | 128 |

| 1235 | puesta | 128 |

| 1236 | gritos | 128 |

| 1237 | entrado | 128 |

| 1238 | clara | 128 |

| 1239 | aldea | 128 |

| 1240 | uso | 127 |

| 1241 | sazón | 127 |

| 1242 | respuesta | 127 |

| 1243 | resolución | 127 |

| 1244 | paredes | 127 |

| 1245 | muchacho | 127 |

| 1246 | mandado | 127 |

| 1247 | llamó | 127 |

| 1248 | frasquito | 127 |

| 1249 | feliz | 127 |

| 1250 | entraron | 127 |

| 1251 | entrada | 127 |

| 1252 | ayuda | 127 |

| 1253 | andrés | 127 |

| 1254 | ricos | 126 |

| 1255 | pequeño | 126 |

| 1256 | palo | 126 |

| 1257 | esperando | 126 |

| 1258 | pompeyo | 125 |

| 1259 | dixo | 125 |

| 1260 | diego | 125 |

| 1261 | celos | 125 |

| 1262 | bosque | 125 |

| 1263 | primeros | 124 |

| 1264 | ozores | 124 |

| 1265 | fijo | 124 |

| 1266 | entusiasmo | 124 |

| 1267 | elvira | 124 |

| 1268 | dijeron | 124 |

| 1269 | diferentes | 124 |

| 1270 | bachiller | 124 |

| 1271 | tomando | 123 |

| 1272 | salieron | 123 |

| 1273 | parecido | 123 |

| 1274 | muchacha | 123 |

| 1275 | interior | 123 |

| 1276 | estupiñá | 123 |

| 1277 | admiración | 123 |

| 1278 | ventero | 122 |

| 1279 | tell | 122 |

| 1280 | sois | 122 |

| 1281 | salen | 122 |

| 1282 | pusieron | 122 |

| 1283 | pude | 122 |

| 1284 | polvo | 122 |

| 1285 | pide | 122 |

| 1286 | partida | 122 |

| 1287 | encontrar | 122 |

| 1288 | conviene | 122 |

| 1289 | contó | 122 |

| 1290 | burla | 122 |

| 1291 | barba | 122 |

| 1292 | aquél | 122 |

| 1293 | acerca | 122 |

| 1294 | tuve | 121 |

| 1295 | rucio | 121 |

| 1296 | prima | 121 |

| 1297 | piensa | 121 |

| 1298 | particular | 121 |

| 1299 | francisca | 121 |

| 1300 | dorotea | 121 |

| 1301 | viera | 120 |

| 1302 | salón | 120 |

| 1303 | salida | 120 |

| 1304 | quizá | 120 |

| 1305 | quedaron | 120 |

| 1306 | quedado | 120 |

| 1307 | pequeña | 120 |

| 1308 | pecados | 120 |

| 1309 | mente | 120 |

| 1310 | ínsula | 120 |

| 1311 | honrada | 120 |

| 1312 | halló | 120 |

| 1313 | ganas | 120 |

| 1314 | estrellas | 120 |

| 1315 | entiende | 120 |

| 1316 | difícil | 120 |

| 1317 | deseaba | 120 |

| 1318 | cuentas | 120 |

| 1319 | antiguo | 120 |

| 1320 | anoche | 120 |

| 1321 | pasaron | 119 |

| 1322 | papeles | 119 |

| 1323 | feijoo | 119 |

| 1324 | entrañas | 119 |

| 1325 | dineros | 119 |

| 1326 | cuándo | 119 |

| 1327 | capilla | 119 |

| 1328 | baldomero | 119 |

| 1329 | zalacaín | 118 |

| 1330 | traído | 118 |

| 1331 | toledo | 118 |

| 1332 | sucesos | 118 |

| 1333 | serlo | 118 |

| 1334 | querían | 118 |

| 1335 | nina | 118 |

| 1336 | infierno | 118 |

| 1337 | demonio | 118 |

| 1338 | acabar | 118 |

| 1339 | vengo | 117 |

| 1340 | vencido | 117 |

| 1341 | señorito | 117 |

| 1342 | rigor | 117 |

| 1343 | patria | 117 |

| 1344 | palos | 117 |

| 1345 | menor | 117 |

| 1346 | melib | 117 |

| 1347 | llega | 117 |

| 1348 | hará | 117 |

| 1349 | extranjero | 117 |

| 1350 | echando | 117 |

| 1351 | deben | 117 |

| 1352 | cuestión | 117 |

| 1353 | trata | 116 |

| 1354 | sucedió | 116 |

| 1355 | perdón | 116 |

| 1356 | haría | 116 |

| 1357 | ganado | 116 |

| 1358 | florentina | 116 |

| 1359 | esté | 116 |

| 1360 | enfermedad | 116 |

| 1361 | colores | 116 |

| 1362 | casta | 116 |

| 1363 | recuerdo | 115 |

| 1364 | motivo | 115 |

| 1365 | ladrón | 115 |

| 1366 | flor | 115 |

| 1367 | envidia | 115 |

| 1368 | cólera | 115 |

| 1369 | chicos | 115 |

| 1370 | casos | 115 |

| 1371 | aurora | 115 |

| 1372 | almas | 115 |

| 1373 | alas | 115 |

| 1374 | venganza | 114 |

| 1375 | teodoro | 114 |

| 1376 | servía | 114 |

| 1377 | sano | 114 |

| 1378 | punta | 114 |

| 1379 | prueba | 114 |

| 1380 | papitos | 114 |

| 1381 | maestro | 114 |

| 1382 | juro | 114 |

| 1383 | discurso | 114 |

| 1384 | aguas | 114 |

| 1385 | acababa | 114 |

| 1386 | espera | 113 |

| 1387 | diligencia | 113 |

| 1388 | creyendo | 113 |

| 1389 | cabellos | 113 |

| 1390 | antigua | 113 |

| 1391 | almudena | 113 |

| 1392 | adiós | 113 |

| 1393 | verano | 112 |

| 1394 | quedar | 112 |

| 1395 | pagar | 112 |

| 1396 | mismos | 112 |

| 1397 | labrador | 112 |

| 1398 | hacerse | 112 |

| 1399 | gesto | 112 |

| 1400 | frase | 112 |

| 1401 | costa | 112 |

| 1402 | cartas | 112 |

| 1403 | caballos | 112 |

| 1404 | vano | 111 |

| 1405 | término | 111 |

| 1406 | quince | 111 |

| 1407 | partido | 111 |

| 1408 | hacerle | 111 |

| 1409 | francés | 111 |

| 1410 | avnque | 111 |

| 1411 | ausencia | 111 |

| 1412 | aparte | 111 |

| 1413 | volviendo | 110 |

| 1414 | seguida | 110 |

| 1415 | reina | 110 |

| 1416 | querría | 110 |

| 1417 | presentes | 110 |

| 1418 | parmeno | 110 |

| 1419 | imagen | 110 |

| 1420 | hombro | 110 |

| 1421 | hijas | 110 |

| 1422 | cruel | 110 |

| 1423 | capaz | 110 |

| 1424 | tonto | 109 |

| 1425 | sabido | 109 |

| 1426 | repuso | 109 |

| 1427 | nuevos | 109 |

| 1428 | materia | 109 |

| 1429 | ii | 109 |

| 1430 | humano | 109 |

| 1431 | fui | 109 |

| 1432 | cantar | 109 |

| 1433 | calla | 109 |

| 1434 | arcipreste | 109 |

| 1435 | pidió | 108 |

| 1436 | pedazos | 108 |

| 1437 | llave | 108 |

| 1438 | fuere | 108 |

| 1439 | dirá | 108 |

| 1440 | bonita | 108 |

| 1441 | basilio | 108 |

| 1442 | ardiente | 108 |

| 1443 | visitación | 107 |

| 1444 | sacerdote | 107 |

| 1445 | pedía | 107 |

| 1446 | muestra | 107 |

| 1447 | mozos | 107 |

| 1448 | ingenio | 107 |

| 1449 | etc | 107 |

| 1450 | español | 107 |

| 1451 | cristianos | 107 |

| 1452 | cogió | 107 |

| 1453 | tuvieron | 106 |

| 1454 | seas | 106 |

| 1455 | rayo | 106 |

| 1456 | pregunta | 106 |

| 1457 | portal | 106 |

| 1458 | plácido | 106 |

| 1459 | pared | 106 |

| 1460 | negros | 106 |

| 1461 | francia | 106 |

| 1462 | extremo | 106 |

| 1463 | enferma | 106 |

| 1464 | diese | 106 |

| 1465 | despacho | 106 |

| 1466 | corría | 106 |

| 1467 | circunstancias | 106 |

| 1468 | ciertos | 106 |

| 1469 | suyos | 105 |

| 1470 | soldados | 105 |

| 1471 | sentimientos | 105 |

| 1472 | priesa | 105 |

| 1473 | pasaban | 105 |

| 1474 | parar | 105 |

| 1475 | orgullo | 105 |

| 1476 | nariz | 105 |

| 1477 | muestras | 105 |

| 1478 | mostraba | 105 |

| 1479 | limosna | 105 |

| 1480 | liberal | 105 |

| 1481 | lenguaje | 105 |

| 1482 | francisco | 105 |

| 1483 | empezaba | 105 |

| 1484 | doctor | 105 |

| 1485 | digno | 105 |

| 1486 | darme | 105 |

| 1487 | comido | 105 |

| 1488 | claridad | 105 |

| 1489 | callar | 105 |

| 1490 | ca | 105 |

| 1491 | parecen | 104 |

| 1492 | ora | 104 |

| 1493 | juanito | 104 |

| 1494 | indicó | 104 |

| 1495 | echado | 104 |

| 1496 | dormía | 104 |

| 1497 | dize | 104 |

| 1498 | daré | 104 |

| 1499 | cristo | 104 |

| 1500 | caminos | 104 |

| 1501 | animal | 104 |

| 1502 | tuviese | 103 |

| 1503 | tomaba | 103 |

| 1504 | siglos | 103 |

| 1505 | reloj | 103 |

| 1506 | necesitaba | 103 |

| 1507 | moros | 103 |

| 1508 | míos | 103 |

| 1509 | menudo | 103 |

| 1510 | ejercicio | 103 |

| 1511 | comía | 103 |

| 1512 | coger | 103 |

| 1513 | capitán | 103 |

| 1514 | acto | 103 |

| 1515 | términos | 102 |

| 1516 | syn | 102 |

| 1517 | soldado | 102 |

| 1518 | salían | 102 |

| 1519 | rincón | 102 |

| 1520 | rica | 102 |

| 1521 | quita | 102 |

| 1522 | niñas | 102 |

| 1523 | humilde | 102 |

| 1524 | gustaba | 102 |

| 1525 | evaristo | 102 |

| 1526 | entero | 102 |

| 1527 | elegante | 102 |

| 1528 | conforme | 102 |

| 1529 | ambas | 102 |

| 1530 | vicio | 101 |

| 1531 | venida | 101 |

| 1532 | sirve | 101 |

| 1533 | responder | 101 |

| 1534 | perros | 101 |

| 1535 | marcial | 101 |

| 1536 | i | 101 |

| 1537 | humo | 101 |

| 1538 | hablaban | 101 |

| 1539 | fuertes | 101 |

| 1540 | dueñas | 101 |

| 1541 | desque | 101 |

| 1542 | cardenio | 101 |

| 1543 | veremos | 100 |

| 1544 | verdaderamente | 100 |

| 1545 | servido | 100 |

| 1546 | palacio | 100 |

| 1547 | nubes | 100 |

| 1548 | mesma | 100 |

| 1549 | máquina | 100 |

| 1550 | hermanos | 100 |

| 1551 | golfín | 100 |

| 1552 | estómago | 100 |

| 1553 | ea | 100 |

| 1554 | diera | 100 |

| 1555 | confusión | 100 |

| 1556 | barbas | 100 |

| 1557 | acaba | 100 |

| 1558 | terror | 99 |

| 1559 | tendrá | 99 |

| 1560 | sentidos | 99 |

| 1561 | reyes | 99 |

| 1562 | repitió | 99 |

| 1563 | pluma | 99 |

| 1564 | moza | 99 |

| 1565 | luscinda | 99 |

| 1566 | ilustre | 99 |

| 1567 | harto | 99 |

| 1568 | éstos | 99 |

| 1569 | deje | 99 |

| 1570 | dedo | 99 |

| 1571 | cuartos | 99 |

| 1572 | cristiana | 99 |

| 1573 | coro | 99 |

| 1574 | común | 99 |

| 1575 | caza | 99 |

| 1576 | autoridad | 99 |

| 1577 | volvieron | 98 |

| 1578 | so | 98 |

| 1579 | seso | 98 |

| 1580 | serio | 98 |

| 1581 | señales | 98 |

| 1582 | política | 98 |

| 1583 | pieza | 98 |

| 1584 | mercedes | 98 |

| 1585 | lope | 98 |

| 1586 | llegando | 98 |

| 1587 | llanto | 98 |

| 1588 | ingleses | 98 |

| 1589 | hubieran | 98 |

| 1590 | herido | 98 |

| 1591 | gozar | 98 |

| 1592 | cuyas | 98 |

| 1593 | cortesía | 98 |

| 1594 | contado | 98 |

| 1595 | compañero | 98 |

| 1596 | cantidad | 98 |

| 1597 | vete | 97 |

| 1598 | tristes | 97 |

| 1599 | terreno | 97 |

| 1600 | ripamilán | 97 |

| 1601 | pasando | 97 |

| 1602 | noticias | 97 |

| 1603 | montes | 97 |

| 1604 | merece | 97 |

| 1605 | lanza | 97 |

| 1606 | gato | 97 |

| 1607 | fuesen | 97 |

| 1608 | existencia | 97 |

| 1609 | enojo | 97 |

| 1610 | emperador | 97 |

| 1611 | delfín | 97 |

| 1612 | cuerpos | 97 |

| 1613 | convento | 97 |

| 1614 | cambio | 97 |

| 1615 | azul | 97 |

| 1616 | árbol | 97 |

| 1617 | verdes | 96 |

| 1618 | quisiere | 96 |

| 1619 | olor | 96 |

| 1620 | observó | 96 |

| 1621 | necesario | 96 |

| 1622 | milagro | 96 |

| 1623 | hojas | 96 |

| 1624 | gozo | 96 |

| 1625 | engaño | 96 |

| 1626 | contaba | 96 |

| 1627 | anterior | 96 |

| 1628 | única | 95 |

| 1629 | sigue | 95 |

| 1630 | pastor | 95 |

| 1631 | narices | 95 |

| 1632 | muertos | 95 |

| 1633 | hidalgo | 95 |

| 1634 | haces | 95 |

| 1635 | fría | 95 |

| 1636 | experiencia | 95 |

| 1637 | encuentro | 95 |

| 1638 | corriente | 95 |

| 1639 | cayetano | 95 |

| 1640 | caballerías | 95 |

| 1641 | tuya | 94 |

| 1642 | temía | 94 |

| 1643 | sonriendo | 94 |

| 1644 | quieras | 94 |

| 1645 | qu | 94 |

| 1646 | matrimonio | 94 |

| 1647 | majestad | 94 |

| 1648 | hazañas | 94 |

| 1649 | curas | 94 |

| 1650 | cuerda | 94 |

| 1651 | carro | 94 |

| 1652 | bendito | 94 |

| 1653 | azotes | 94 |

| 1654 | vuelva | 93 |

| 1655 | verme | 93 |

| 1656 | tomás | 93 |

| 1657 | tendría | 93 |

| 1658 | ridículo | 93 |

| 1659 | ratos | 93 |

| 1660 | quedo | 93 |

| 1661 | penas | 93 |

| 1662 | metido | 93 |

| 1663 | llevaban | 93 |

| 1664 | juventud | 93 |

| 1665 | honrado | 93 |

| 1666 | hábito | 93 |

| 1667 | guarda | 93 |

| 1668 | foja | 93 |

| 1669 | fino | 93 |

| 1670 | discreción | 93 |

| 1671 | dejaron | 93 |

| 1672 | decirse | 93 |

| 1673 | darse | 93 |

| 1674 | dame | 93 |

| 1675 | cuyos | 93 |

| 1676 | come | 93 |

| 1677 | carga | 93 |

| 1678 | andan | 93 |

| 1679 | víctima | 92 |

| 1680 | varios | 92 |

| 1681 | rara | 92 |

| 1682 | pueblos | 92 |

| 1683 | parís | 92 |

| 1684 | nombres | 92 |

| 1685 | murmuró | 92 |

| 1686 | mata | 92 |

| 1687 | marcha | 92 |

| 1688 | malicia | 92 |

| 1689 | llamaban | 92 |

| 1690 | herida | 92 |

| 1691 | habitación | 92 |

| 1692 | guardar | 92 |

| 1693 | dormido | 92 |

| 1694 | diferencia | 92 |

| 1695 | descubierto | 92 |

| 1696 | debían | 92 |

| 1697 | cumplir | 92 |

| 1698 | corre | 92 |

| 1699 | consuelo | 92 |

| 1700 | comprar | 92 |

| 1701 | catalina | 92 |

| 1702 | vosotros | 91 |

| 1703 | tranquilo | 91 |

| 1704 | sentado | 91 |

| 1705 | piso | 91 |

| 1706 | periódicos | 91 |

| 1707 | limpio | 91 |

| 1708 | importancia | 91 |

| 1709 | hiciera | 91 |

| 1710 | hallaba | 91 |

| 1711 | fiesta | 91 |

| 1712 | espiritual | 91 |

| 1713 | escuela | 91 |

| 1714 | doncellas | 91 |

| 1715 | desto | 91 |

| 1716 | comercio | 91 |

| 1717 | caía | 91 |

| 1718 | amar | 91 |

| 1719 | alguien | 91 |

| 1720 | acercó | 91 |

| 1721 | tertulia | 90 |

| 1722 | tellagorri | 90 |

| 1723 | rayos | 90 |

| 1724 | puestos | 90 |

| 1725 | profundo | 90 |

| 1726 | profunda | 90 |

| 1727 | pongo | 90 |

| 1728 | peso | 90 |

| 1729 | llenos | 90 |

| 1730 | letra | 90 |

| 1731 | glocester | 90 |

| 1732 | galán | 90 |

| 1733 | esfuerzo | 90 |

| 1734 | escuadra | 90 |

| 1735 | energía | 90 |

| 1736 | educación | 90 |

| 1737 | echaba | 90 |

| 1738 | dispuesto | 90 |

| 1739 | cuantas | 90 |

| 1740 | cola | 90 |

| 1741 | cincuenta | 90 |

| 1742 | ciento | 90 |

| 1743 | asiento | 90 |

| 1744 | artículo | 90 |

| 1745 | aliento | 90 |

| 1746 | vanidad | 89 |

| 1747 | tratar | 89 |

| 1748 | tiro | 89 |

| 1749 | seda | 89 |

| 1750 | satisfecho | 89 |

| 1751 | murió | 89 |

| 1752 | licenciado | 89 |

| 1753 | jardín | 89 |

| 1754 | infame | 89 |

| 1755 | escena | 89 |

| 1756 | escándalo | 89 |

| 1757 | enfrente | 89 |

| 1758 | diría | 89 |

| 1759 | detuvo | 89 |

| 1760 | crea | 89 |

| 1761 | consejos | 89 |

| 1762 | compasión | 89 |

| 1763 | cárcel | 89 |

| 1764 | camisa | 89 |

| 1765 | traigo | 88 |

| 1766 | trabajos | 88 |

| 1767 | trabajar | 88 |

| 1768 | sonrisa | 88 |

| 1769 | seno | 88 |

| 1770 | sacaba | 88 |

| 1771 | respecto | 88 |

| 1772 | recordaba | 88 |

| 1773 | ó | 88 |

| 1774 | maldito | 88 |

| 1775 | iré | 88 |

| 1776 | invierno | 88 |

| 1777 | huesos | 88 |

| 1778 | hacerlo | 88 |

| 1779 | gentil | 88 |

| 1780 | estuviera | 88 |

| 1781 | espero | 88 |

| 1782 | destos | 88 |

| 1783 | criatura | 88 |

| 1784 | corrió | 88 |

| 1785 | compañeros | 88 |

| 1786 | buscaba | 88 |

| 1787 | blancas | 88 |

| 1788 | veían | 87 |

| 1789 | tonta | 87 |

| 1790 | tocar | 87 |

| 1791 | sentó | 87 |

| 1792 | pensado | 87 |

| 1793 | pedazo | 87 |

| 1794 | olvido | 87 |

| 1795 | nieve | 87 |

| 1796 | madera | 87 |

| 1797 | levantar | 87 |

| 1798 | jefe | 87 |

| 1799 | dignidad | 87 |

| 1800 | crees | 87 |

| 1801 | contenta | 87 |

| 1802 | altas | 87 |

| 1803 | abrir | 87 |

| 1804 | s | 86 |

| 1805 | relaciones | 86 |

| 1806 | primeras | 86 |

| 1807 | preguntar | 86 |

| 1808 | pase | 86 |

| 1809 | oyeron | 86 |

| 1810 | md | 86 |

| 1811 | luces | 86 |

| 1812 | felicidad | 86 |

| 1813 | excelente | 86 |

| 1814 | especialmente | 86 |

| 1815 | entendía | 86 |

| 1816 | conde | 86 |

| 1817 | casarse | 86 |

| 1818 | casar | 86 |

| 1819 | saca | 85 |

| 1820 | respondía | 85 |

| 1821 | ramos | 85 |

| 1822 | perdida | 85 |

| 1823 | orgaz | 85 |

| 1824 | nueve | 85 |

| 1825 | monjas | 85 |

| 1826 | levantarse | 85 |

| 1827 | leguas | 85 |

| 1828 | juez | 85 |

| 1829 | hallar | 85 |

| 1830 | fresco | 85 |

| 1831 | espejo | 85 |

| 1832 | espanto | 85 |

| 1833 | desdichado | 85 |

| 1834 | descanso | 85 |

| 1835 | cuasi | 85 |

| 1836 | creí | 85 |

| 1837 | confesar | 85 |

| 1838 | comedias | 85 |

| 1839 | aqui | 85 |

| 1840 | alegres | 85 |

| 1841 | abierto | 85 |

| 1842 | valía | 84 |

| 1843 | valeroso | 84 |

| 1844 | torre | 84 |

| 1845 | sucedido | 84 |

| 1846 | singular | 84 |

| 1847 | semblante | 84 |

| 1848 | pobreza | 84 |

| 1849 | olvidado | 84 |

| 1850 | momentos | 84 |

| 1851 | miraban | 84 |

| 1852 | mías | 84 |

| 1853 | figuras | 84 |

| 1854 | feo | 84 |

| 1855 | fecho | 84 |

| 1856 | entrando | 84 |

| 1857 | destas | 84 |

| 1858 | corredor | 84 |

| 1859 | conocimiento | 84 |

| 1860 | bella | 84 |

| 1861 | alonso | 84 |

| 1862 | vió | 83 |

| 1863 | templo | 83 |

| 1864 | sofá | 83 |

| 1865 | recibió | 83 |

| 1866 | poderoso | 83 |

| 1867 | necesito | 83 |

| 1868 | mostrar | 83 |

| 1869 | meter | 83 |

| 1870 | mandar | 83 |

| 1871 | fuente | 83 |

| 1872 | dulces | 83 |

| 1873 | cena | 83 |

| 1874 | bienes | 83 |

| 1875 | barco | 83 |

| 1876 | vuestros | 82 |

| 1877 | viejos | 82 |

| 1878 | subía | 82 |

| 1879 | queriendo | 82 |

| 1880 | prudente | 82 |

| 1881 | principales | 82 |

| 1882 | pierde | 82 |

| 1883 | páez | 82 |

| 1884 | órdenes | 82 |

| 1885 | linaje | 82 |

| 1886 | ligero | 82 |

| 1887 | hallado | 82 |

| 1888 | guimarán | 82 |

| 1889 | gritaba | 82 |

| 1890 | época | 82 |

| 1891 | dezir | 82 |

| 1892 | confesión | 82 |

| 1893 | centro | 82 |

| 1894 | cansado | 82 |

| 1895 | broma | 82 |

| 1896 | bajó | 82 |

| 1897 | baile | 82 |

| 1898 | amigas | 82 |

| 1899 | tendré | 81 |

| 1900 | tadeo | 81 |

| 1901 | superior | 81 |

| 1902 | sabían | 81 |

| 1903 | quise | 81 |

| 1904 | orejas | 81 |

| 1905 | norte | 81 |

| 1906 | nobleza | 81 |

| 1907 | necesita | 81 |

| 1908 | juntas | 81 |

| 1909 | inglés | 81 |

| 1910 | graves | 81 |

| 1911 | escudos | 81 |

| 1912 | escribe | 81 |

| 1913 | dizes | 81 |

| 1914 | distancia | 81 |

| 1915 | digna | 81 |

| 1916 | debió | 81 |

| 1917 | daría | 81 |

| 1918 | cuarenta | 81 |

| 1919 | carnes | 81 |

| 1920 | cadena | 81 |

| 1921 | botas | 81 |

| 1922 | alcanzar | 81 |

| 1923 | agradable | 81 |

| 1924 | ten | 80 |

| 1925 | suma | 80 |

| 1926 | salvo | 80 |

| 1927 | sacando | 80 |

| 1928 | ramas | 80 |

| 1929 | pierna | 80 |

| 1930 | periódico | 80 |

| 1931 | lobo | 80 |

| 1932 | junta | 80 |

| 1933 | golpes | 80 |

| 1934 | espalda | 80 |

| 1935 | discreta | 80 |

| 1936 | dijera | 80 |

| 1937 | digas | 80 |

| 1938 | dellas | 80 |

| 1939 | cuesta | 80 |

| 1940 | caras | 80 |

| 1941 | caña | 80 |

| 1942 | canto | 80 |

| 1943 | adónde | 80 |

| 1944 | acciones | 80 |

| 1945 | acabado | 80 |

| 1946 | vuelvo | 79 |

| 1947 | vela | 79 |

| 1948 | riendo | 79 |

| 1949 | prendas | 79 |

| 1950 | ponga | 79 |

| 1951 | poetas | 79 |

| 1952 | poesía | 79 |

| 1953 | pico | 79 |

| 1954 | ocasiones | 79 |

| 1955 | mandaba | 79 |

| 1956 | izquierda | 79 |

| 1957 | inútil | 79 |

| 1958 | forzoso | 79 |

| 1959 | estuvieron | 79 |

| 1960 | estará | 79 |

| 1961 | amantes | 79 |

| 1962 | acción | 79 |

| 1963 | zoraida | 78 |

| 1964 | tuyo | 78 |

| 1965 | tormento | 78 |

| 1966 | teniendo | 78 |

| 1967 | temprano | 78 |

| 1968 | tema | 78 |

| 1969 | sufrir | 78 |

| 1970 | solamente | 78 |

| 1971 | santísima | 78 |

| 1972 | sansón | 78 |

| 1973 | sabemos | 78 |

| 1974 | romualdo | 78 |

| 1975 | propios | 78 |

| 1976 | presa | 78 |

| 1977 | paga | 78 |

| 1978 | mancebo | 78 |

| 1979 | leche | 78 |

| 1980 | ganar | 78 |

| 1981 | fiera | 78 |

| 1982 | fiel | 78 |

| 1983 | falda | 78 |

| 1984 | fabla | 78 |

| 1985 | éstas | 78 |

| 1986 | dijese | 78 |

| 1987 | dándole | 78 |

| 1988 | casado | 78 |

| 1989 | cádiz | 78 |

| 1990 | bajar | 78 |

| 1991 | aspecto | 78 |

| 1992 | vivero | 77 |

| 1993 | visitas | 77 |

| 1994 | verte | 77 |

| 1995 | triunfo | 77 |

| 1996 | serán | 77 |

| 1997 | saliendo | 77 |

| 1998 | quitado | 77 |

| 1999 | puerto | 77 |

| 2000 | pudiese | 77 |

| 2001 | probar | 77 |

| 2002 | podré | 77 |

| 2003 | pesadumbre | 77 |

| 2004 | mostró | 77 |

| 2005 | mortal | 77 |

| 2006 | monja | 77 |

| 2007 | ministro | 77 |

| 2008 | males | 77 |

| 2009 | horrible | 77 |

| 2010 | historias | 77 |

| 2011 | fazer | 77 |

| 2012 | estuve | 77 |

| 2013 | estaría | 77 |

| 2014 | defensa | 77 |

| 2015 | dará | 77 |

| 2016 | conoció | 77 |

| 2017 | castigo | 77 |

| 2018 | calavera | 77 |

| 2019 | apareció | 77 |

| 2020 | acento | 77 |

| 2021 | vestida | 76 |

| 2022 | vendrá | 76 |

| 2023 | social | 76 |

| 2024 | siente | 76 |

| 2025 | seguridad | 76 |

| 2026 | roto | 76 |

| 2027 | presentó | 76 |

| 2028 | preguntas | 76 |

| 2029 | podemos | 76 |

| 2030 | plazer | 76 |

| 2031 | plato | 76 |

| 2032 | jumento | 76 |

| 2033 | jáuregui | 76 |

| 2034 | ja | 76 |

| 2035 | importaba | 76 |

| 2036 | huir | 76 |

| 2037 | genio | 76 |

| 2038 | divina | 76 |

| 2039 | disposición | 76 |

| 2040 | cristales | 76 |

| 2041 | corta | 76 |

| 2042 | corregidor | 76 |

| 2043 | cenar | 76 |

| 2044 | calma | 76 |

| 2045 | tocaba | 75 |

| 2046 | título | 75 |

| 2047 | sosiego | 75 |

| 2048 | seré | 75 |

| 2049 | nobles | 75 |

| 2050 | gordo | 75 |

| 2051 | esperanzas | 75 |

| 2052 | encontrado | 75 |

| 2053 | das | 75 |

| 2054 | combate | 75 |

| 2055 | atrevió | 75 |

| 2056 | apetito | 75 |

| 2057 | afirmó | 75 |

| 2058 | tercera | 74 |

| 2059 | suyas | 74 |

| 2060 | suspiros | 74 |

| 2061 | sor | 74 |

| 2062 | sierra | 74 |

| 2063 | semana | 74 |

| 2064 | queréis | 74 |

| 2065 | próxima | 74 |

| 2066 | prado | 74 |

| 2067 | plumas | 74 |

| 2068 | plática | 74 |

| 2069 | pasados | 74 |

| 2070 | oy | 74 |

| 2071 | mando | 74 |

| 2072 | limpia | 74 |

| 2073 | irse | 74 |

| 2074 | industria | 74 |

| 2075 | impresión | 74 |

| 2076 | ilusión | 74 |

| 2077 | humildad | 74 |

| 2078 | hable | 74 |

| 2079 | gravedad | 74 |

| 2080 | fija | 74 |

| 2081 | eh | 74 |

| 2082 | dia | 74 |

| 2083 | cristal | 74 |

| 2084 | corriendo | 74 |

| 2085 | coraçón | 74 |

| 2086 | comprender | 74 |

| 2087 | bromas | 74 |

| 2088 | bermúdez | 74 |

| 2089 | beber | 74 |

| 2090 | asimismo | 74 |

| 2091 | arma | 74 |

| 2092 | andando | 74 |

| 2093 | volviéndose | 73 |

| 2094 | villalonga | 73 |

| 2095 | supuesto | 73 |

| 2096 | suelta | 73 |

| 2097 | severiana | 73 |

| 2098 | seria | 73 |

| 2099 | samaniego | 73 |

| 2100 | revés | 73 |

| 2101 | provincia | 73 |

| 2102 | pintado | 73 |

| 2103 | perlas | 73 |

| 2104 | perfectamente | 73 |

| 2105 | paño | 73 |

| 2106 | pago | 73 |

| 2107 | locos | 73 |

| 2108 | largas | 73 |

| 2109 | haz | 73 |

| 2110 | gracioso | 73 |

| 2111 | extraño | 73 |

| 2112 | estudiante | 73 |

| 2113 | esquina | 73 |

| 2114 | disparate | 73 |

| 2115 | díjole | 73 |

| 2116 | dígame | 73 |

| 2117 | desnudo | 73 |

| 2118 | dejaban | 73 |

| 2119 | decís | 73 |

| 2120 | altar | 73 |

| 2121 | abierta | 73 |

| 2122 | vecino | 72 |

| 2123 | sed | 72 |

| 2124 | religiosa | 72 |

| 2125 | recibir | 72 |

| 2126 | paje | 72 |

| 2127 | mirad | 72 |

| 2128 | manifestó | 72 |

| 2129 | ladrones | 72 |

| 2130 | jugar | 72 |

| 2131 | joaquín | 72 |

| 2132 | inocencio | 72 |

| 2133 | hacerme | 72 |

| 2134 | garganta | 72 |

| 2135 | estancia | 72 |

| 2136 | efeto | 72 |

| 2137 | diablos | 72 |

| 2138 | destino | 72 |

| 2139 | dejo | 72 |

| 2140 | culto | 72 |

| 2141 | convenía | 72 |

| 2142 | casada | 72 |

| 2143 | caballuco | 72 |

| 2144 | boda | 72 |

| 2145 | balcones | 72 |

| 2146 | avn | 72 |

| 2147 | viese | 71 |

| 2148 | tratado | 71 |

| 2149 | tome | 71 |

| 2150 | sospecha | 71 |

| 2151 | plan | 71 |

| 2152 | pido | 71 |

| 2153 | papá | 71 |

| 2154 | oí | 71 |

| 2155 | negocios | 71 |

| 2156 | mulas | 71 |

| 2157 | maneras | 71 |

| 2158 | maldita | 71 |

| 2159 | lógica | 71 |

| 2160 | llevan | 71 |

| 2161 | leía | 71 |

| 2162 | evitar | 71 |

| 2163 | estuviese | 71 |

| 2164 | establecimiento | 71 |

| 2165 | entrambos | 71 |

| 2166 | digan | 71 |

| 2167 | dichoso | 71 |

| 2168 | desprecio | 71 |

| 2169 | cuántas | 71 |

| 2170 | calidad | 71 |

| 2171 | barca | 71 |

| 2172 | vinieron | 70 |

| 2173 | vencer | 70 |

| 2174 | vecinos | 70 |

| 2175 | temo | 70 |

| 2176 | sujeto | 70 |

| 2177 | rumor | 70 |

| 2178 | romper | 70 |

| 2179 | reía | 70 |

| 2180 | propias | 70 |

| 2181 | precio | 70 |

| 2182 | obligado | 70 |

| 2183 | minutos | 70 |

| 2184 | medios | 70 |

| 2185 | manto | 70 |

| 2186 | lucha | 70 |

| 2187 | llevo | 70 |

| 2188 | hiciese | 70 |

| 2189 | fresca | 70 |

| 2190 | falsa | 70 |

| 2191 | escuderos | 70 |

| 2192 | desdén | 70 |

| 2193 | corona | 70 |

| 2194 | clérigos | 70 |

| 2195 | cielos | 70 |

| 2196 | campos | 70 |

| 2197 | cabello | 70 |

| 2198 | burlas | 70 |

| 2199 | atrevido | 70 |

| 2200 | amos | 70 |

| 2201 | voto | 69 |

| 2202 | villa | 69 |

| 2203 | supiera | 69 |

| 2204 | sistema | 69 |

| 2205 | serían | 69 |

| 2206 | remedios | 69 |

| 2207 | quitó | 69 |

| 2208 | quedan | 69 |

| 2209 | parientes | 69 |

| 2210 | pálido | 69 |

| 2211 | pájaros | 69 |

| 2212 | ofreció | 69 |

| 2213 | ocurrió | 69 |

| 2214 | negar | 69 |

| 2215 | multitud | 69 |

| 2216 | muere | 69 |

| 2217 | muera | 69 |

| 2218 | mérito | 69 |

| 2219 | lugares | 69 |

| 2220 | llorando | 69 |

| 2221 | jóvenes | 69 |

| 2222 | inocente | 69 |

| 2223 | ex | 69 |

| 2224 | ejército | 69 |

| 2225 | den | 69 |

| 2226 | corazon | 69 |

| 2227 | cobarde | 69 |

| 2228 | celio | 69 |

| 2229 | cae | 69 |

| 2230 | ave | 69 |

| 2231 | asombro | 69 |

| 2232 | vivos | 68 |

| 2233 | viven | 68 |

| 2234 | tranquila | 68 |

| 2235 | tela | 68 |

| 2236 | sube | 68 |

| 2237 | sabiendo | 68 |

| 2238 | pública | 68 |

| 2239 | precisamente | 68 |

| 2240 | poniéndose | 68 |

| 2241 | piezas | 68 |

| 2242 | perdone | 68 |

| 2243 | pasiones | 68 |

| 2244 | nota | 68 |

| 2245 | nosotras | 68 |

| 2246 | movía | 68 |

| 2247 | frases | 68 |

| 2248 | empresa | 68 |

| 2249 | crédito | 68 |

| 2250 | comprendió | 68 |

| 2251 | cerró | 68 |

| 2252 | cerrar | 68 |

| 2253 | blancos | 68 |

| 2254 | bestia | 68 |

| 2255 | armado | 68 |

| 2256 | vuelo | 67 |

| 2257 | viniese | 67 |

| 2258 | viejas | 67 |

| 2259 | vetustenses | 67 |

| 2260 | techo | 67 |

| 2261 | suceder | 67 |

| 2262 | sublime | 67 |

| 2263 | simple | 67 |

| 2264 | quedaban | 67 |

| 2265 | prometido | 67 |

| 2266 | príncipe | 67 |

| 2267 | pecador | 67 |

| 2268 | pastores | 67 |

| 2269 | ofrecía | 67 |

| 2270 | mismas | 67 |

| 2271 | metió | 67 |

| 2272 | mejillas | 67 |

| 2273 | m | 67 |

| 2274 | libres | 67 |

| 2275 | leyó | 67 |

| 2276 | iguales | 67 |

| 2277 | hilo | 67 |

| 2278 | habido | 67 |

| 2279 | desgraciado | 67 |

| 2280 | demonios | 67 |

| 2281 | débil | 67 |

| 2282 | cueva | 67 |

| 2283 | castellano | 67 |

| 2284 | cabezas | 67 |

| 2285 | aya | 67 |

| 2286 | villano | 66 |

| 2287 | tomo | 66 |

| 2288 | tercero | 66 |

| 2289 | suspiro | 66 |

| 2290 | quede | 66 |

| 2291 | petronila | 66 |

| 2292 | permitía | 66 |

| 2293 | oración | 66 |

| 2294 | navíos | 66 |

| 2295 | maravillas | 66 |

| 2296 | madres | 66 |

| 2297 | llenas | 66 |

| 2298 | línea | 66 |

| 2299 | levantándose | 66 |

| 2300 | influencia | 66 |

| 2301 | imaginar | 66 |

| 2302 | iii | 66 |

| 2303 | gigante | 66 |

| 2304 | frutos | 66 |

| 2305 | filosofía | 66 |

| 2306 | figuraba | 66 |

| 2307 | faz | 66 |

| 2308 | error | 66 |

| 2309 | enteramente | 66 |

| 2310 | dizen | 66 |

| 2311 | despertó | 66 |

| 2312 | dejan | 66 |

| 2313 | deber | 66 |

| 2314 | crimen | 66 |

| 2315 | completamente | 66 |

| 2316 | cautivo | 66 |

| 2317 | caserón | 66 |

| 2318 | carretera | 66 |

| 2319 | bonito | 66 |

| 2320 | atrevía | 66 |

| 2321 | arnaiz | 66 |

| 2322 | areu | 66 |

| 2323 | altos | 66 |

| 2324 | aires | 66 |

| 2325 | tren | 65 |

| 2326 | sueños | 65 |

| 2327 | suave | 65 |

| 2328 | sotana | 65 |

| 2329 | sonreía | 65 |

| 2330 | salvaje | 65 |

| 2331 | salto | 65 |

| 2332 | sacado | 65 |

| 2333 | riqueza | 65 |

| 2334 | rabia | 65 |

| 2335 | principios | 65 |

| 2336 | preso | 65 |

| 2337 | prenda | 65 |

| 2338 | oreja | 65 |

| 2339 | obscuridad | 65 |

| 2340 | notó | 65 |

| 2341 | mia | 65 |

| 2342 | mentiras | 65 |

| 2343 | llevaron | 65 |

| 2344 | lenguas | 65 |

| 2345 | lector | 65 |

| 2346 | haberle | 65 |

| 2347 | graciosa | 65 |

| 2348 | formas | 65 |

| 2349 | fea | 65 |

| 2350 | estrecho | 65 |

| 2351 | española | 65 |

| 2352 | entera | 65 |

| 2353 | encantadores | 65 |

| 2354 | dirección | 65 |

| 2355 | creído | 65 |

| 2356 | cogido | 65 |

| 2357 | claramente | 65 |

| 2358 | cera | 65 |

| 2359 | barrio | 65 |

| 2360 | atento | 65 |

| 2361 | agravio | 65 |

| 2362 | acudir | 65 |

| 2363 | vetustense | 64 |

| 2364 | traían | 64 |

| 2365 | tenéis | 64 |

| 2366 | taberna | 64 |

| 2367 | susto | 64 |

| 2368 | sepultura | 64 |

| 2369 | seco | 64 |

| 2370 | recado | 64 |

| 2371 | procuraba | 64 |

| 2372 | princesa | 64 |

| 2373 | presteza | 64 |

| 2374 | negras | 64 |

| 2375 | muda | 64 |

| 2376 | muchachos | 64 |

| 2377 | mora | 64 |

| 2378 | medicina | 64 |

| 2379 | maese | 64 |

| 2380 | luis | 64 |

| 2381 | locuras | 64 |

| 2382 | hermosas | 64 |

| 2383 | furioso | 64 |

| 2384 | fantasía | 64 |

| 2385 | fácilmente | 64 |

| 2386 | escucha | 64 |

| 2387 | duelo | 64 |

| 2388 | continuó | 64 |

| 2389 | caja | 64 |

| 2390 | bolsillo | 64 |

| 2391 | besos | 64 |

| 2392 | asuntos | 64 |

| 2393 | antiguos | 64 |

| 2394 | ángeles | 64 |

| 2395 | andado | 64 |

| 2396 | vezes | 63 |

| 2397 | usar | 63 |

| 2398 | últimos | 63 |

| 2399 | tesoro | 63 |

| 2400 | temeroso | 63 |

| 2401 | talle | 63 |

| 2402 | soberbia | 63 |

| 2403 | sintiendo | 63 |

| 2404 | sevilla | 63 |

| 2405 | sereno | 63 |

| 2406 | salí | 63 |

| 2407 | renegado | 63 |

| 2408 | razon | 63 |

| 2409 | quisiese | 63 |

| 2410 | puntos | 63 |

| 2411 | premio | 63 |

| 2412 | piel | 63 |

| 2413 | pereza | 63 |

| 2414 | parque | 63 |

| 2415 | pariente | 63 |

| 2416 | nervios | 63 |

| 2417 | mona | 63 |

| 2418 | modos | 63 |

| 2419 | intento | 63 |

| 2420 | importante | 63 |

| 2421 | faltar | 63 |

| 2422 | estudio | 63 |

| 2423 | espolón | 63 |

| 2424 | diversas | 63 |

| 2425 | cuerdo | 63 |

| 2426 | comenzaron | 63 |

| 2427 | capital | 63 |

| 2428 | bárbara | 63 |

| 2429 | acudió | 63 |

| 2430 | virtudes | 62 |

| 2431 | victoria | 62 |

| 2432 | usaba | 62 |

| 2433 | tomé | 62 |

| 2434 | sentencia | 62 |

| 2435 | satisfacción | 62 |

| 2436 | responde | 62 |

| 2437 | repetía | 62 |

| 2438 | propuso | 62 |

| 2439 | principalmente | 62 |

| 2440 | pasan | 62 |

| 2441 | pasada | 62 |

| 2442 | honestidad | 62 |

| 2443 | fina | 62 |

| 2444 | fiebre | 62 |

| 2445 | escribió | 62 |

| 2446 | escribano | 62 |

| 2447 | encantado | 62 |

| 2448 | emoción | 62 |

| 2449 | cuentos | 62 |

| 2450 | cubierto | 62 |

| 2451 | confieso | 62 |

| 2452 | confesonario | 62 |

| 2453 | completo | 62 |

| 2454 | civil | 62 |

| 2455 | caída | 62 |

| 2456 | botica | 62 |

| 2457 | ataque | 62 |

| 2458 | arena | 62 |

| 2459 | animales | 62 |

| 2460 | alzó | 62 |

| 2461 | altisidora | 62 |

| 2462 | afición | 62 |

| 2463 | acero | 62 |

| 2464 | verso | 61 |

| 2465 | vara | 61 |

| 2466 | supe | 61 |

| 2467 | secretos | 61 |

| 2468 | saco | 61 |

| 2469 | penitencia | 61 |

| 2470 | pasillo | 61 |

| 2471 | ofrece | 61 |

| 2472 | muero | 61 |

| 2473 | movimientos | 61 |

| 2474 | isla | 61 |

| 2475 | hallo | 61 |

| 2476 | hallé | 61 |

| 2477 | hagas | 61 |

| 2478 | furia | 61 |

| 2479 | fatiga | 61 |

| 2480 | falso | 61 |

| 2481 | espectáculo | 61 |

| 2482 | escudo | 61 |

| 2483 | engañado | 61 |

| 2484 | disimular | 61 |

| 2485 | disgusto | 61 |

| 2486 | déjame | 61 |

| 2487 | defender | 61 |

| 2488 | decirlo | 61 |